En la carrera por el dominio de la Inteligencia Artificial, tener el mejor software ya no es suficiente. Microsoft lo sabe y, tras años dependiendo casi exclusivamente de terceros, ha dado un golpe sobre la mesa con la presentación del Maia 200. Este nuevo acelerador de IA no es solo una actualización técnica; es la pieza central de una estrategia para reducir la dependencia de Nvidia y optimizar los costes de la nube a una escala sin precedentes.

Mucho más que transistores: El salto a los 3 nanómetros

Mientras que su predecesor (el Maia 100) sentó las bases, el Maia 200 representa un salto generacional masivo. Fabricado con la tecnología de 3 nanómetros de TSMC, este chip alberga en su interior más de 140.000 millones de transistores.

¿Qué significa esto en la práctica? Una densidad de computación asombrosa que permite procesar modelos de lenguaje inmensos (como los futuros GPT de OpenAI) con una eficiencia energética que hasta hace poco parecía inalcanzable. Con un consumo de 750W, Microsoft ha logrado un equilibrio crítico: maximizar la potencia sin que la factura eléctrica de sus centros de datos se dispare.

La batalla de la «Inferencia»: El verdadero cuello de botella

A menudo se habla mucho del entrenamiento de la IA, pero el verdadero reto económico hoy es la inferencia (el momento en que la IA responde a un usuario en tiempo real). Aquí es donde el Maia 200 brilla especialmente:

- Rendimiento por dólar: Microsoft asegura que este chip es un 30% más eficiente en términos de coste que cualquier hardware previo en su flota.

- Memoria ultra rápida: Equipado con 216 GB de memoria HBM3e, el chip elimina los «atascos» de datos, permitiendo que la información fluya a una velocidad de 7 TB/s.

Un ecosistema diseñado para escalar

Lo más interesante de este anuncio no es solo el chip individual, sino cómo se conectan entre sí. Microsoft ha diseñado una arquitectura de red que permite agrupar hasta 6.144 aceleradores en un solo clúster. Esto convierte a los centros de datos de Azure en superordenadores modulares capaces de mover trillones de parámetros casi al instante.

Además, el lanzamiento viene acompañado del Maia SDK, un kit de desarrollo que facilita a los ingenieros la portabilidad de sus modelos actuales al nuevo hardware, asegurando que el cambio de piezas no suponga un dolor de cabeza logístico.

¿Por qué debería importarnos?

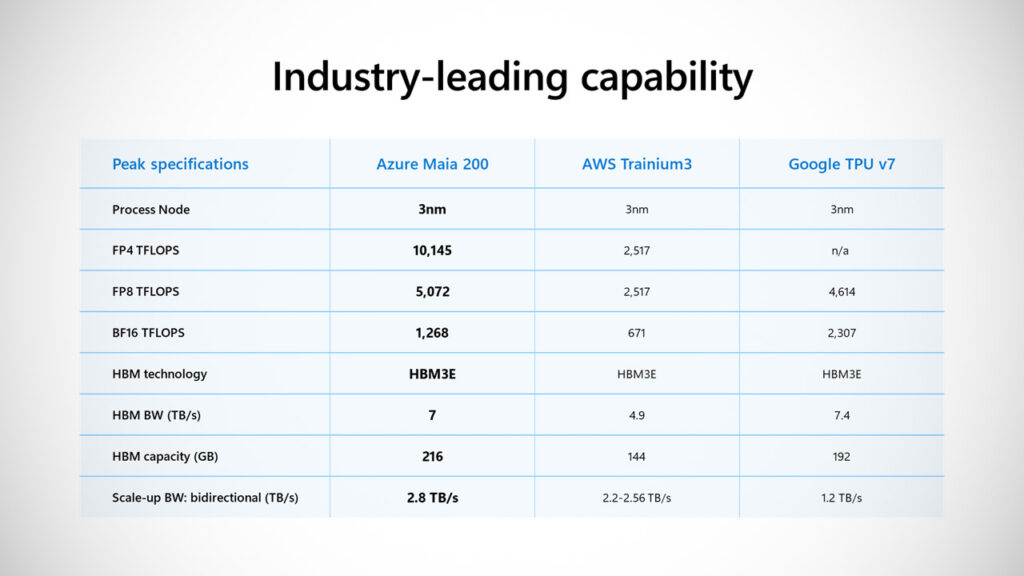

Este movimiento posiciona a Microsoft no solo como un gigante del software, sino como un diseñador de hardware de élite, compitiendo directamente con las soluciones personalizadas de Google (TPU) y Amazon (Trainium).

Para el usuario final, esto se traduce en una IA más rápida, servicios como Copilot más integrados y, potencialmente, una reducción en los precios de los servicios en la nube gracias a la optimización de costes que el Maia 200 trae consigo. Microsoft no solo quiere participar en la revolución de la IA; quiere ser el dueño de la infraestructura que la sostiene.